Vidí, slyší a umí předstírat emoce. GPT-4o posunuje úroveň AI chatbotů a část svých schopností nabídne zdarma

Zdroj: OpenAI

Pondělní tisková konference OpenAI budila velká očekávání. Velká část z nich počítala s propojením ChatGPT4 s online vyhledáváním a oznámením spojenectví s dalšími službami. Přišlo ale něco lepšího: GPT-4o. Rychlejší a energeticky úspornější jazykový model, který budí dojem schopnějšího a lidštějšího parťáka.

Pozor nejde o špatně napsanou číslovku „40“, „o“ je je počátečním písmenem slova „omnimodel“ odkazující na skutečnou multimodalitu nejnovější vrze AI chatbota. Už ChatGPT-4 umělo identifikovat, co je na obrázku, převádět své textové odpovědi na hlas a v podobě mobilní aplikaci i přijímat hlasové pokyny. GPT-4o to zvládne bez převádění a přepínání v pozadí — jako by šlo o smysly, které mu jsou vlastní. OpenAI k tomu říká:

„Před GPT-4o bylo možné v hlasovém režimu komunikovat s ChatGPT s průměrnou latencí 2,8 sekundy (GPT-3.5) a 5,4 sekundy (GPT-4). Aby toho bylo dosaženo, je hlasový režim soustavou tří samostatných modelů: jeden jednoduchý model přepisuje zvuk na text, GPT-3.5 nebo GPT-4 přijímá a vytváří text a třetí jednoduchý model převádí tento text zpět na zvuk. Tento proces znamená, že hlavní zdroj inteligence, GPT-4, ztrácí mnoho informací — nemůže přímo pozorovat tón, více mluvčích nebo zvuky v pozadí a nemůže vyprodukovat smích, zpěv nebo vyjádřit emoce.

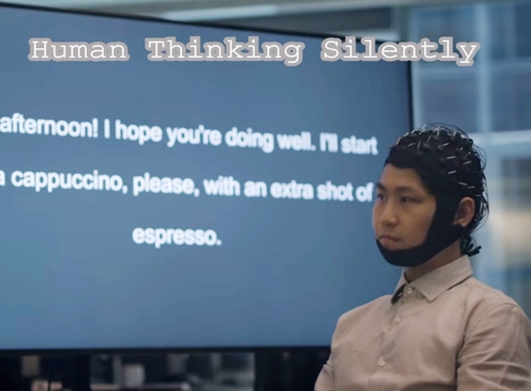

S GPT-4o jsme vycvičili jeden nový model end-to-end pro text, obraz a zvuk, což znamená, že všechny vstupy a výstupy jsou zpracovávány stejnou neuronovou sítí. Protože je GPT-4o naším prvním modelem kombinujícím všechny tyto modality, stále jsme jen na začátku toho zkoumání, co model dokáže a kde jsou jeho limity.“

Už dosavadní schopnosti „čtyřky“ znamenaly velký posun v tom, co může AI nabídnout jako osobní asistent. Následující video ukazující, jak může nový omnimodel suplovat zrak a popisovat svět člověku se sníženým viděním, ovšem ilustruje, že tato verze může při své rychlosti fungovat ještě řádově lépe.

Zejména poslední z příkladů s přijíždějícím taxíkem je testamentem rychlosti nového modelu. „Na zvukové vstupy dokáže reagovat za pouhých 232 milisekund, v průměru za 320 milisekund, což je podobná doba reakce jako u člověka při rozhovoru. Shoduje se s výkonem GPT-4 Turbo u textu v angličtině a kódu, přičemž u textu v neanglických jazycích je výrazně lepší, a zároveň je mnohem rychlejší a o 50 % levnější v API,“ přibližuje OpenAI. Odkazem na cenu přitom míní to, že nespotřebovává tolik počítačového výkonu a tím i energie. Je totiž ne příliš často zdůrazňovaným faktem, že „pokec s AI chatbotem“ není zdaleka uhlíkově neutrální a zaměstnává na dálku výkonné počítače.

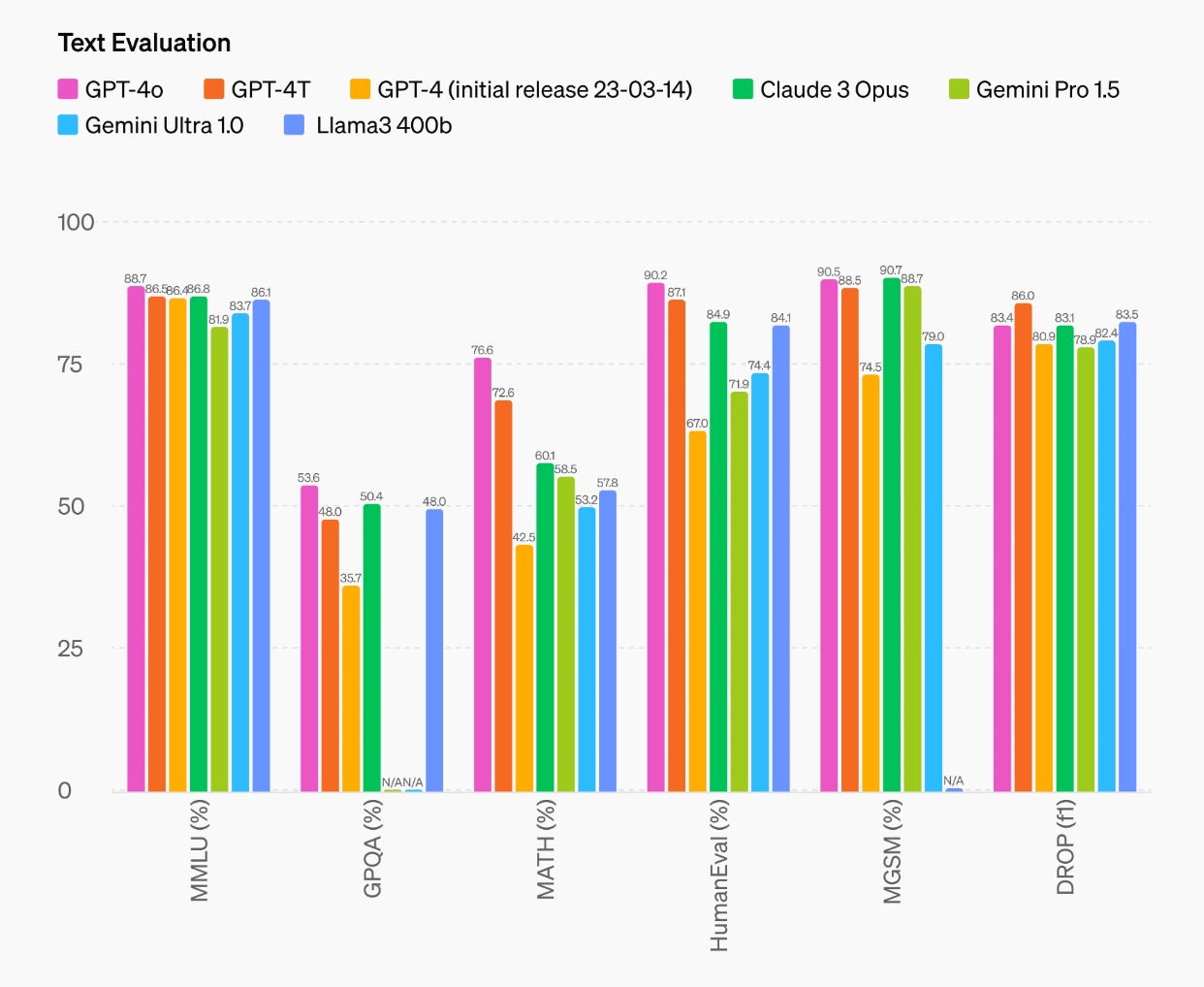

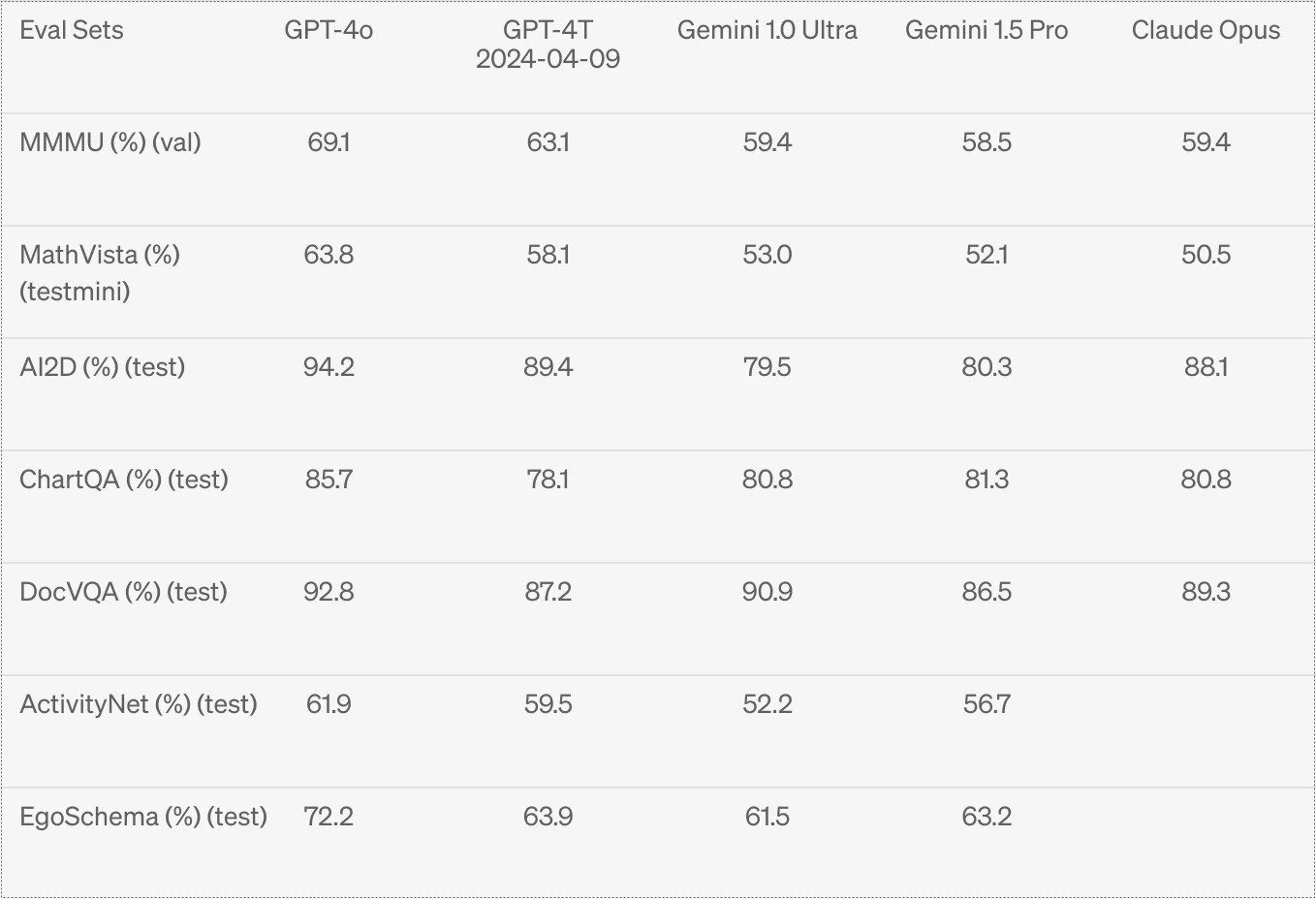

GPT-4o je přitom na špičce i co se týče samotného výkonu. Na grafu níže je porovnání s dalšími jazykovými modely v MLMU testech, které simulují test znalostí podobně na školech. Posuzuje schopnost porozumění textu, dialog s člověkem a další „rozumové atributy“. Výrazněji překonává konkurenci v matematice, kde je i mírně lepší než GPT-4 Turbo a o desítky procentních bodů lepší než ChatGPT-4.

Veškerou konkurenci převyšuje ve vizuálním porozumění.

Zdroj: OpenAI

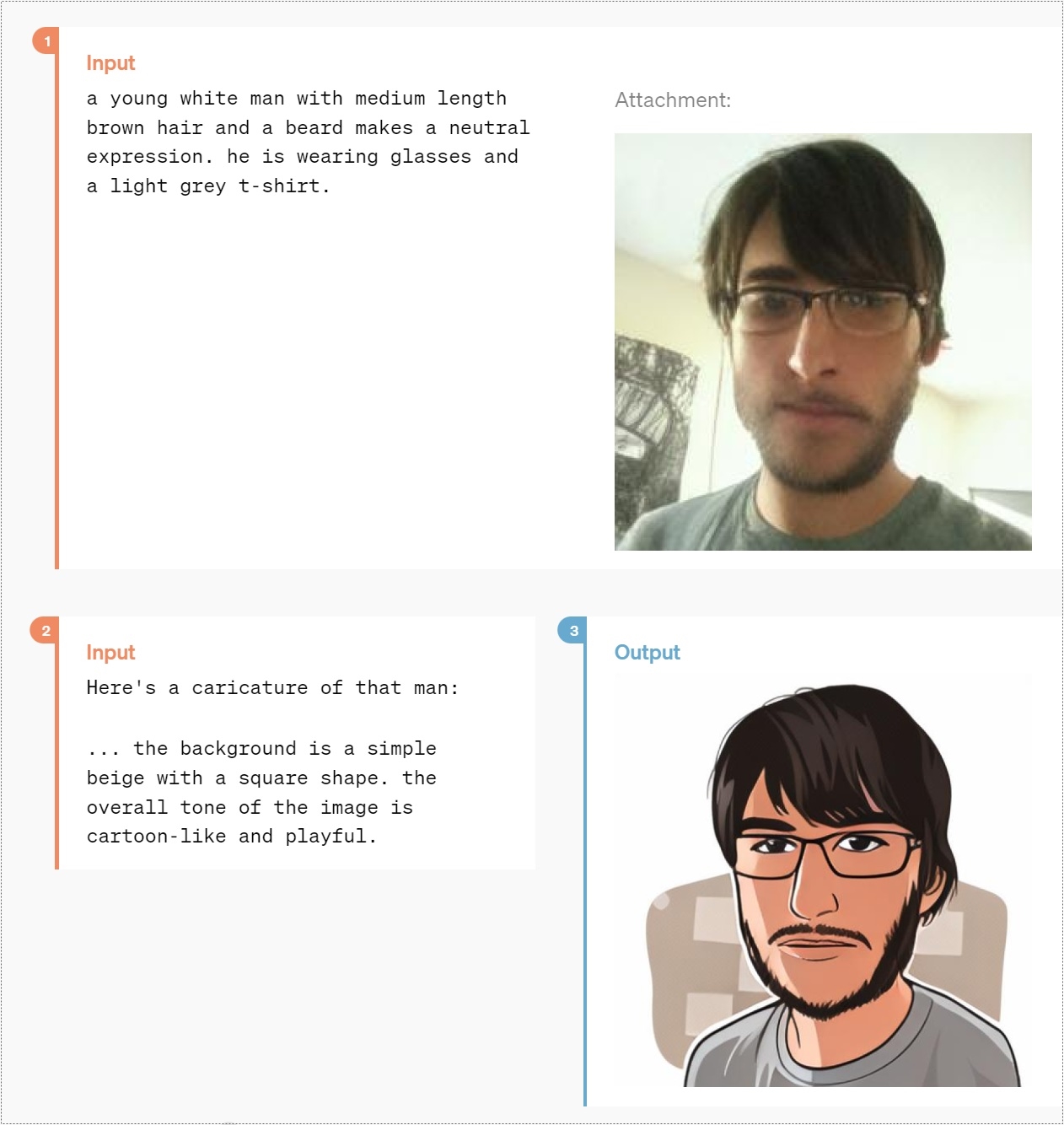

V jedněch z mnoha ukázek sdílených OpenAI ilustruje tyto schopnosti třeba na vytvoření digitálního avatara z fotografie, pokročilejších využití bude ale celá řada.

Omračující jsou zejména ukázky rychlosti interakce s GPT-4o. Posuďte míru emocí, kterou dokáže dodat do konverzace.

Sarkasmus je něco, co velká část lidí nechápe a „neumí“. GPT-4o ho zvládá.

Dva chatboty si dokážou spolu „pokecat“ a dokonce i zazpívat (ve video po 4:30).

Umí i zazpívat dítěti ukolébavku na jakékoliv téma.

Následující video pak ukazuje simultánní překlad ze španělštiny.

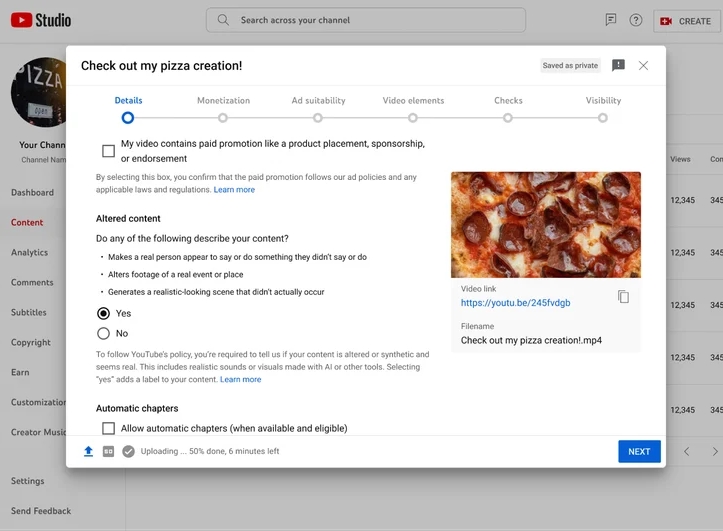

Velká dávka funkci bude zdarma

Pro lidi, kteří nepatří mezi dosavadní předplatitele, je nejzásadnější informací, že mnoho z předvedených „kouzel“ bude k dispozici zdarma. OpenAI tak chce zprostředkovat tyto možnosti:

-

- Zkušenosti s inteligencí na úrovni GPT-4

- Získávání odpovědí z modelu i z webu

- Analýza dat a tvorba grafů

- Chatování o pořízených fotografiích

- Možnost nahrát soubory pro pomoc při shrnutí, psaní nebo analýze.

- Používání GPTs a GPT Store (dosud jen v GPT-4 a GPT-4 Turbo, pozn. red.)

- Využívání větší paměti jazykového modelu

- Zkušenosti s inteligencí na úrovni GPT-4

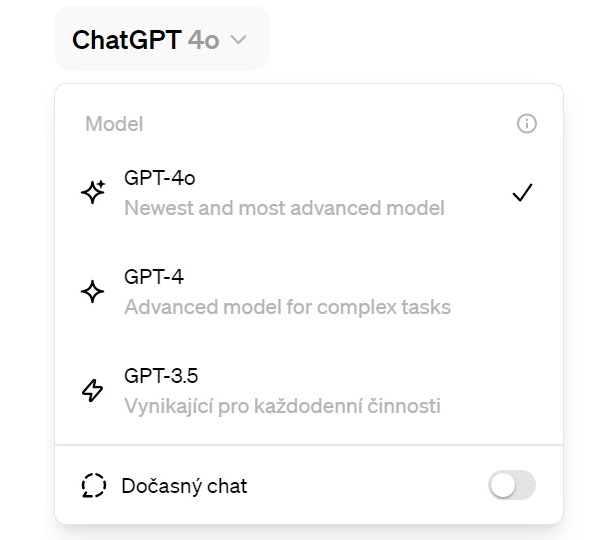

Už nyní si můžou ti šťastnější z vás v rozhraní ChatGPT na nový model přepnout. Jedná se o globální roll-out, který bývá vždy postupný. Někteří čtenáři nám hlásí, že u nich možnost ChatGPT-4o nevidí.

Zdroj: OpenAI

„Velmi důležitou součástí našeho poslání je zpřístupnit naše pokročilé nástroje umělé inteligence všem zdarma. Myslíme si, že je nesmírně důležité, aby lidé věděli, co tato technologie dokáže,“ uvedla během tiskové konference technická ředitelka Mira Murati. Realisticky předpokládáme, že pokud by daný stav vedl k odlivu placených předplatitelů, změní se to. Spíše tak bereme dané rozhodnutí jako další snahu o „AI pobláznění“ většího množství globální populace a přitáhnutí ji v době schopnostmi velmi podobných jazykových modelů k těm od OpenAI, která nyní nabízí interakci, jež se nejvíce blíží té s člověkem.